Väčšina robotov je dobre navrhnutá a nespôsobuje vlastníkom stránok žiadne problémy. Ak je však robot napísaný amatérom alebo „niečo sa pokazilo“, môže to spôsobiť značné zaťaženie stránky, ktoré obchádza. Mimochodom, pavúky vôbec nevstupujú na server ako vírusy - jednoducho si vzdialene vyžiadajú stránky, ktoré potrebujú (v skutočnosti ide o analógy prehliadačov, ale bez funkcie prehliadania stránok).

Robots.txt – príkaz user-agent a roboty vyhľadávacieho nástroja

Robots.txt má veľmi jednoduchú syntax, ktorá je veľmi podrobne popísaná napríklad v pomôcť yandex a Pomocník Google. Zvyčajne určuje, pre ktorého vyhľadávacieho robota sú určené nasledujúce direktívy: názov robota (" user-agent"), dovoľovať (" povoliť") a zakazujúce (" Zakázať") a "Sitemap" sa tiež aktívne používa na označenie vyhľadávacích nástrojov, kde presne sa súbor mapy nachádza.

Štandard vznikol pomerne dávno a niečo sa pridalo až neskôr. Existujú smernice a pravidlá dizajnu, ktoré pochopia iba roboty určitých vyhľadávačov. V RuNet sú zaujímavé iba Yandex a Google, čo znamená, že s ich pomocou pri kompilácii robots.txt by ste sa mali obzvlášť podrobne zoznámiť (odkazy som uviedol v predchádzajúcom odseku).

Napríklad skôr pre vyhľadávací nástroj Yandex bolo užitočné uviesť, že váš webový projekt je hlavným projektom v špeciálnej smernici „Host“, ktorej rozumie iba tento vyhľadávací nástroj (dobre, aj Mail.ru, pretože majú vyhľadávanie z Yandex). Pravda, začiatkom roka 2018 Yandex stále zrušil hostiteľa a teraz jeho funkcie, podobne ako funkcie iných vyhľadávačov, vykonáva presmerovanie 301.

Aj keď váš zdroj nemá zrkadlá, bude užitočné uviesť, ktorý z pravopisov je hlavný - .

Teraz si povedzme trochu o syntaxi tohto súboru. Smernice v súbore robots.txt vyzerajú takto:

<поле>:<пробел><значение><пробел> <поле>:<пробел><значение><пробел>

Správny kód by mal obsahovať aspoň jednu direktívu „Disallow“. po každom zázname „User-agent“. Prázdny súbor predpokladá povolenie indexovať celú lokalitu.

user-agent

Direktíva „User-agent“. musí obsahovať názov vyhľadávacieho robota. Pomocou neho môžete nastaviť pravidlá správania pre každý konkrétny vyhľadávací nástroj (napríklad vytvoriť zákaz indexovania samostatného priečinka iba pre Yandex). Príklad napísania „User-agenta“ adresovaného všetkým robotom, ktorí prichádzajú do vášho zdroja, vyzerá takto:

User-agent: *

Ak chcete nastaviť určité podmienky v „User-agent“ iba pre jedného robota, napríklad Yandex, musíte napísať toto:

Používateľský agent: Yandex

Názov robotov vyhľadávacieho nástroja a ich úloha v súbore robots.txt

Bot každého vyhľadávača má svoj vlastný názov (napríklad pre ramblera je to StackRambler). Tu uvediem najznámejšie z nich:

Google http://www.google.com Googlebot Yandex http://www.ya.ru Yandex Bing http://www.bing.com/ bingbot

Pre veľké vyhľadávače niekedy okrem hlavných robotov, existujú aj samostatné inštancie na indexovanie blogov, správ, obrázkov a podobne. Môžete získať veľa informácií o typoch robotov (pre Yandex) a (pre Google).

Ako byť v tomto prípade? Ak potrebujete napísať pravidlo zákazu indexovania, ktoré musia dodržiavať všetky typy robotov Googlebot, použite názov Googlebot a všetky ostatné pavúky tohto vyhľadávača sa budú tiež riadiť. Môžete však zakázať napríklad indexovanie obrázkov iba tak, že ako User-agent určíte robota Googlebot-Image. Teraz to nie je veľmi jasné, ale s príkladmi si myslím, že to bude jednoduchšie.

Príklady použitia príkazov Disallow a Allow v súbore robots.txt

Dovoľte mi uviesť niekoľko jednoduchých príklady použitia smerníc vysvetľovať svoje činy.

- Nižšie uvedený kód umožňuje všetkým robotom (označeným hviezdičkou v User-agentovi) indexovať všetok obsah bez akýchkoľvek výnimiek. Je to dané prázdny Direktíva Disallow. User-agent: * Disallow:

- Nasledujúci kód naopak úplne zakazuje všetkým vyhľadávacím nástrojom pridávať stránky tohto zdroja do indexu. Nastaví to na Disallow s "/" v poli hodnoty. User-agent: * Disallow: /

- V tomto prípade budú mať všetky roboty zakázané prezerať obsah adresára /image/ (http://mysite.ru/image/ je absolútna cesta k tomuto adresáru) User-agent: * Disallow: /image/

- Na zablokovanie jedného súboru bude stačiť zaregistrovať jeho absolútnu cestu k nemu (čítať): User-agent: * Disallow: /katalog1//katalog2/private_file.html

Keď sa pozriem trochu dopredu, poviem, že je jednoduchšie použiť znak hviezdičky (*), aby ste nepísali celú cestu:

Disallow: /*private_file.html

- V nižšie uvedenom príklade bude zakázaný adresár "image", ako aj všetky súbory a adresáre, ktoré začínajú znakmi "image", t.j. súbory: "image.htm", "images.htm", adresáre: "image" , " images1", "image34" atď.): User-agent: * Disallow: /image Faktom je, že štandardne je na konci záznamu uvedená hviezdička, ktorá nahrádza akékoľvek znaky, vrátane ich absencie. Prečítajte si o tom nižšie.

- Používaním povoliť direktívy umožňujeme prístup. Dobre dopĺňa Disallow. S touto podmienkou napríklad zakážeme vyhľadávaciemu robotu Yandex sťahovať (indexovať) všetko okrem webových stránok, ktorých adresa začína /cgi-bin: User-agent: Yandex Allow: /cgi-bin Disallow: /

Alebo toto je jasný príklad použitia balíka Povoliť a Zakázať:

User-agent: * Disallow: /catalog Allow: /catalog/auto

- Pri popise ciest pre direktívy Allow-Disallow môžete použiť symboly "*" a "$", čím sa nastavia určité logické výrazy.

- Symbol "*"(hviezda) znamená akúkoľvek (vrátane prázdnych) sekvencií znakov. Nasledujúci príklad bráni všetkým vyhľadávacím nástrojom v indexovaní súborov s príponou „.php“: User-agent: * Disallow: *.php$

- Prečo je to potrebné na konci znak $ (dolár).? Faktom je, že podľa logiky kompilácie súboru robots.txt sa na koniec každej smernice pridá predvolená hviezdička (neexistuje, ale zdá sa, že tam je). Napríklad napíšeme: Disallow: /images

Za predpokladu, že je to rovnaké ako:

Disallow: /images*

Tie. toto pravidlo zakazuje indexovanie všetkých súborov (webových stránok, obrázkov a iných typov súborov), ktorých adresa začína na /images a čokoľvek iné nasleduje (pozri príklad vyššie). Takže tu to je symbol $ jednoducho prepíše tú predvolenú (nešpecifikovanú) hviezdičku na konci. Napríklad:

Disallow: /images$

Zakáže indexovanie iba súboru /images, nie /images.html alebo /images/primer.html. V prvom príklade sme zakázali indexovať iba súbory končiace na .php (s takouto koncovkou), aby sme nezachytili nič navyše:

Disallow: *.php$

Hviezdička za otáznikom sa naznačuje sama o sebe, no ako sme zistili o niečo vyššie, je už naznačená na konci. Preto zakážeme indexovanie vyhľadávacích stránok a iných servisných stránok vytvorených motorom, na ktoré sa vyhľadávací robot dostane. Nebude to zbytočné, pretože otáznik najčastejšie používa CMS ako identifikátor relácie, čo môže viesť k tomu, že sa do indexu dostanú duplicitné stránky.

Smernice Sitemap a Host (pre Yandex) v súbore Robots.txt

Aby sa predišlo nepríjemným problémom so zrkadlami stránok, predtým sa odporúčalo pridať do robots.txt smernicu Host, ktorá nasmerovala robota Yandex na hlavné zrkadlo.

Hostiteľská smernica - určuje hlavné zrkadlo stránky pre Yandex

Napríklad predtým, ak si ešte neprešli na zabezpečený protokol, bolo potrebné uviesť v hostiteľovi nie celú URL, ale názov domény (bez http://, t.j. .ru). Ak ste už prešli na https, budete musieť zadať úplnú adresu URL (napríklad https://myhost.ru).

Skvelý nástroj na boj s duplicitným obsahom – vyhľadávač jednoducho nezaindexuje stránku, ak je v Canonicale zaregistrovaná iná adresa URL. Napríklad pri takejto stránke môjho blogu (stránka so stránkovaním) Canonical odkazuje na https: // stránku a nemali by byť žiadne problémy s duplikovaním názvov.

Ale to odbočujem...

Ak je váš projekt založený na akomkoľvek motore, potom dôjde k duplicitnému obsahu s vysokou pravdepodobnosťou, čo znamená, že s tým musíte bojovať, a to aj pomocou zákazu v súbore robots.txt a najmä v metaznačke, pretože v prvom prípade môže Google ignorovať zákaz, ale už nemôže dať sakra o metaznačke (takto vychovanej).

Napríklad vo WordPress môžu vyhľadávače indexovať stránky s veľmi podobným obsahom, ak je indexovanie povolené pre obsah kategórií, obsah archívu značiek a obsah dočasného archívu. Ak však použijete metaznačku Robots opísanú vyššie na vytvorenie zákazu pre archív značiek a dočasný archív (značky môžete ponechať, ale zakázať indexovanie obsahu kategórií), duplikácia obsahu nenastane. Ako to urobiť, je popísané v odkaze uvedenom vyššie (na doplnok OlInSeoPak)

Keď to zhrniem, poviem, že súbor Robots je určený na nastavenie globálnych pravidiel na odmietnutie prístupu k celým adresárom lokality alebo k súborom a priečinkom, ktorých názvy obsahujú špecifikované znaky (podľa masky). Príklady nastavenia takýchto zákazov môžete vidieť o niečo vyššie.

Teraz sa pozrime na konkrétne príklady robotov určených pre rôzne motory – Joomla, WordPress a SMF. Prirodzene, všetky tri možnosti vytvorené pre rôzne CMS sa budú od seba výrazne (ak nie zásadne) líšiť. Je pravda, že všetci budú mať jeden spoločný moment a tento moment je spojený s vyhľadávacím nástrojom Yandex.

Pretože Yandex má v Runete pomerne veľkú váhu, potom musíte vziať do úvahy všetky nuansy jeho práce a tu Hostiteľská smernica pomôže. Explicitne to tomuto vyhľadávaču označí hlavné zrkadlo vašej stránky.

Pre ňu sa odporúča použiť samostatný blog User-agent, určený iba pre Yandex (User-agent: Yandex). Dôvodom je skutočnosť, že iné vyhľadávače nemusia hostiteľovi rozumieť, a preto jeho zahrnutie do záznamu User-agent určeného pre všetky vyhľadávače (User-agent: *) môže viesť k negatívnym dôsledkom a nesprávnemu indexovaniu.

Je ťažké povedať, ako sa veci skutočne majú, pretože vyhľadávacie algoritmy sú vecou samy osebe, takže je lepšie robiť to, čo radia. V tomto prípade však budete musieť v direktíve User-agent: Yandex duplikovať všetky pravidlá, ktoré sme nastavili User-agent: * . Ak necháte User-agent: Yandex s prázdnou Disallow: , potom týmto spôsobom umožníte Yandexu ísť kamkoľvek a pretiahnuť všetko do indexu.

Roboty pre WordPress

Nebudem uvádzať príklad súboru, ktorý odporúčajú vývojári. Môžete si to pozrieť sami. Mnoho blogerov vôbec neobmedzuje roboty Yandex a Google vo svojich prechádzkach po obsahu motora WordPress. Najčastejšie na blogoch nájdete roboty automaticky naplnené pluginom.

Ale podľa môjho názoru by sa stále malo pomáhať hľadaniu v neľahkej úlohe preosievať zrno od pliev. Po prvé, robotom Yandex a Google bude trvať veľa času na indexovanie tohto odpadu a na pridanie webových stránok s vašimi novými článkami do indexu nemusí byť vôbec čas. Po druhé, roboty prechádzajúce cez nevyžiadané súbory motora vytvoria dodatočné zaťaženie na serveri vášho hostiteľa, čo nie je dobré.

Sami si môžete pozrieť moju verziu tohto súboru. Je starý, dlho sa nemení, ale snažím sa riadiť zásadou „neopravuj, čo sa nepokazilo“ a je len na tebe, ako sa rozhodneš: použi to, vyrob si svoje alebo odkukaj od niekoho iného . Ešte nedávno som tam mal zákaz indexovania stránok so stránkovaním (Disallow: */page/), no nedávno som ho odstránil, spoliehajúc sa na Canonical, o ktorom som písal vyššie.

Ale vo všeobecnosti, jediný správny súbor pre WordPress pravdepodobne neexistuje. Je samozrejme možné v ňom implementovať akékoľvek predpoklady, ale kto povedal, že budú správne. Na webe je veľa možností ideálneho súboru robots.txt.

Uvediem dva extrémy:

- môžete nájsť megasúbor s podrobnými vysvetleniami (symbol # oddeľuje komentáre, ktoré by bolo lepšie odstrániť v skutočnom súbore): User-agent: * # všeobecné pravidlá pre roboty, okrem Yandex a Google, # pretože pravidlá pre nich sú nižšie Disallow: /cgi-bin # hostingový priečinok Disallow: /? # všetky možnosti dotazu na hlavnej stránke Zakázať: /wp- # všetky súbory WP: /wp-json/, /wp-includes, /wp-content/plugins Zakázať: /wp/ # ak existuje podadresár /wp/, kde CMS je nainštalovaný (ak nie, # pravidlo môže byť odstránené) Disallow: *?s= # search Disallow: *&s= # search Disallow: /search/ # search Disallow: /author/ # archív autora Disallow: /users/ # archív autorov Disallow: */ trackback # trackbacks, upozornenia v komentároch, keď sa objaví otvorený # odkaz na článok Disallow: */feed # all feeds Disallow: */rss # rss feed Disallow: */embed # all embeds Disallow: */wlwmanifest .xml # manifest xml súbor Windows Live Writer (ak nepoužívate, # môže byť odstránený) Disallow: /xmlrpc.php # WordPress API súbor Disallow: *utm= # odkazy so značkami utm Disallow: *openstat= # odkazy so značkami openstat Povoliť : */uploads # otvorený priečinok s nahrávaním súborov User-agent: GoogleBot # pravidlá pre Google (neduplikovať komentáre) Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */ rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm= Disallow: *openstat= Allow: */uploads Allow: /*/*.js # open js scripts inside /wp - (/*/ - pre prioritu) Povoliť: /*/*.css # otvárať súbory css vo vnútri /wp- (/*/ - pre prioritu) Povoliť: /wp-*.png # obrázky v zásuvných moduloch, priečinku vyrovnávacej pamäte atď. Povoliť: /wp-*.jpg # obrázky v zásuvných moduloch, priečinku vyrovnávacej pamäte atď. Povoliť: /wp-*.jpeg # obrázky v zásuvných moduloch, priečinku vyrovnávacej pamäte atď. Povoliť: /wp-*.gif # obrázky v zásuvných moduloch, priečinku vyrovnávacej pamäte atď. Povoliť: /wp-admin/admin-ajax.php # používané pluginmi na zamedzenie blokovania JS a CSS User-agent: Pravidlá Yandex # pre Yandex (neduplikovať komentáre) Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */ rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Povoliť: */uploads Allow: /*/*.js Povoliť: /*/*.css Povoliť: /wp-*.png Povoliť: /wp-*.jpg Povoliť: /wp-*.jpeg Povoliť: /wp-*.gif Povoliť: /wp-admin/admin-ajax.php Clean-Param: utm_source&utm_medium&utm_campaign # Yandex odporúča nezatvárať # z indexovania, ale vymazať parametre značky, # Google takéto pravidlá nepodporuje Clean-Param: openstat # podobné # Zadajte jeden alebo viac súborov Sitemap (nie je potrebné duplikovať pre každého User-agenta #). Google XML Sitemap vytvorí 2 sitemapy ako v príklade nižšie. Sitemap: http://site.ru/sitemap.xml Sitemap: http://site.ru/sitemap.xml.gz # Zadajte hlavné zrkadlo lokality, ako v príklade nižšie (s WWW / bez WWW, ak HTTPS # potom napíšte protokol, ak potrebujete špecifikovať port, špecifikujte). Príkaz hostiteľa rozumie # Yandex a Mail.RU, Google neberie do úvahy. Hostiteľ: www.site.ru

- Tu je príklad minimalizmu: User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php Hostiteľ: https://site.ru Sitemap: https://site.ru/ sitemap.xml

Pravda je zrejme niekde uprostred. Nezabudnite si tiež zaregistrovať metaznačku Robots pre „extra“ stránky, napríklad pomocou úžasného pluginu - . Tiež pomôže nastaviť Canonical.

Opravte súbor robots.txt pre Joomla

User-agent: * Disallow: /administrator/ Disallow: /bin/ Disallow: /cache/ Disallow: /cli/ Disallow: /components/ Disallow: /includes/ Disallow: /installation/ Disallow: /language/ Disallow: /layouts/ Disallow: /libraries/ Disallow: /logs/ Disallow: /modules/ Disallow: /plugins/ Disallow: /tmp/

V zásade sa tu počíta takmer so všetkým a funguje to dobre. Jediná vec je, že by ste k nemu mali pridať samostatné pravidlo User-agent: Yandex, aby ste vložili smernicu Host, ktorá definuje hlavné zrkadlo pre Yandex, ako aj špecifikujte cestu k súboru Sitemap.

Preto by v konečnej podobe mali správne roboty pre Joomlu podľa môjho názoru vyzerať takto:

User-agent: Yandex Disallow: /administrator/ Disallow: /cache/ Disallow: /includes/ Disallow: /installation/ Disallow: /language/ Disallow: /libraries/ Disallow: /modules/ Disallow: /plugins/ Disallow: /tmp/ Disallow: /layouts/ Disallow: /cli/ Disallow: /bin/ Disallow: /logs/ Disallow: /components/ Disallow: /component/ Disallow: /component/tags* Disallow: /*mailto/ Disallow: /*.pdf Disallow : /*% Disallow: /index.php Hostiteľ: vash_sait.ru (alebo www.vash_sait.ru) User-agent: * Povoliť: /*.css?*$ Povoliť: /*.js?*$ Povoliť: /* .jpg?*$ Povoliť: /*.png?*$ Disallow: /administrator/ Disallow: /cache/ Disallow: /includes/ Disallow: /installation/ Disallow: /language/ Disallow: /libraries/ Disallow: /modules/ Disallow : /plugins/ Disallow: /tmp/ Disallow: /layouts/ Disallow: /cli/ Disallow: /bin/ Disallow: /logs/ Disallow: /components/ Disallow: /component/ Disallow: /*mailto/ Disallow: /*. pdf Disallow: /*% Disallow: /index.php Sitemap: http://cesta k vašej mape XML formát

Áno, tiež si všimnite, že v druhej možnosti sú smernice Povoliť, umožňujúce indexovanie štýlov, skriptov a obrázkov. Toto bolo napísané špeciálne pre Google, pretože jeho Googlebot niekedy prisahá, že indexovanie týchto súborov je v robotoch zakázané, napríklad z priečinka s použitou témou. Dokonca za to hrozí znížením hodnotenia.

Preto umožňujeme toto celé vopred indexovať pomocou Allow. Mimochodom, to isté sa stalo vo vzorovom súbore pre WordPress.

Veľa šťastia! Uvidíme sa čoskoro na stránkach blogu

Ďalšie videá si môžete pozrieť na stránke");">Možno vás bude zaujímať

Domény s www a bez www – história ich vzhľadu pomocou presmerovaní 301 na ich zlepenie

Zrkadlá, duplicitné stránky a Url adresy – audit vášho webu alebo čo môže byť príčinou pádu pri jeho SEO propagácii

To si vyžaduje návod na prácu, vyhľadávače nie sú výnimkou z pravidla, a preto prišli so špeciálnym súborom tzv robots.txt. Tento súbor sa musí nachádzať v koreňovom priečinku vašej lokality alebo môže byť virtuálny, ale musí byť otvorený na požiadanie: www.yoursite.ru/robots.txt

Vyhľadávače sa už dávno naučili rozlíšiť potrebné html súbory od interných sád skriptov vášho CMS systému, respektíve sa naučili rozpoznávať odkazy na obsahové články a všelijaké svinstvá. Mnohí webmasteri preto už zabúdajú robiť pre svoje stránky robotu a myslia si, že aj tak bude všetko v poriadku. Áno, majú na 99% pravdu, pretože ak vaša stránka nemá tento súbor, vyhľadávacie nástroje sú neobmedzené pri hľadaní obsahu, existujú však nuansy, o ktoré sa dá vopred postarať.

Ak máte nejaké problémy s týmto súborom na stránke, napíšte komentáre k tomuto článku a ja vám s tým rýchlo pomôžem, úplne zadarmo. Veľmi často sa v ňom webmasteri dopúšťajú drobných chýb, čo privádza web k slabému indexovaniu, či dokonca vyradeniu z indexu.

Na čo slúži robots.txt?

Súbor robots.txt je vytvorený na nastavenie správneho indexovania stránky vyhľadávačmi. To znamená, že obsahuje pravidlá na povolenie a odmietnutie určitých ciest vášho webu alebo typu obsahu. Ale to nie je všeliek. Všetky pravidlá v súbore robots nie sú usmerneniami postupujte presne podľa nich, ale len odporúčanie pre vyhľadávače. Google píše napríklad:

Na skrytie stránky z výsledkov vyhľadávania Google nemôžete použiť súbor robots.txt. Môžu naň odkazovať iné stránky a bude stále indexovaný.

Vyhľadávacie roboty samy rozhodujú, čo indexovať a čo nie a ako sa na stránke správať. Každý vyhľadávací nástroj má svoje vlastné úlohy a funkcie. Akokoľvek by sme chceli, toto je spôsob, ako ich neskrotiť.

Ale je tu jeden trik, ktorý priamo nesúvisí s témou tohto článku. Ak chcete úplne zabrániť robotom v indexovaní a zobrazovaní stránky vo výsledkoch vyhľadávania, musíte napísať:

Vráťme sa k robote. Pravidlá v tomto súbore môžu zatvoriť alebo povoliť prístup k nasledujúcim typom súborov:

- Negrafické súbory. V podstate ide o html súbory, ktoré obsahujú nejaké informácie. Môžete zatvoriť duplicitné stránky alebo stránky, ktoré neposkytujú žiadne užitočné informácie (stránky stránkovania, stránky kalendára, stránky archívu, stránky profilu atď.).

- Grafické súbory. Ak chcete, aby sa obrázky stránok nezobrazovali vo vyhľadávaní, môžete to nastaviť v robotoch.

- Zdrojové súbory. Pomocou robotov môžete tiež zablokovať indexovanie rôznych skriptov, súborov štýlov CSS a iných nedôležitých zdrojov. Nemali by ste však blokovať zdroje, ktoré sú zodpovedné za vizuálnu časť stránky pre návštevníkov (ak napríklad zatvoríte css a js stránky, ktoré zobrazujú krásne bloky alebo tabuľky, vyhľadávací robot to neuvidí a bude nadávať na to).

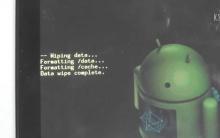

Ak chcete vizuálne ukázať, ako roboty fungujú, pozrite sa na obrázok nižšie:

Vyhľadávací robot, ktorý sleduje stránku, sa pozrie na pravidlá indexovania a potom začne indexovať podľa odporúčaní súboru.  V závislosti od nastavenia pravidiel vyhľadávací nástroj vie, čo je možné indexovať a čo indexovať nie.

V závislosti od nastavenia pravidiel vyhľadávací nástroj vie, čo je možné indexovať a čo indexovať nie.

So syntaxou súboru robots.txt

Na písanie pravidiel pre vyhľadávače v súbore robots sa používajú direktívy s rôznymi parametrami, pomocou ktorých sa roboty riadia. Začnime úplne prvou a pravdepodobne najdôležitejšou smernicou:

Direktíva user-agent

user-agent- Pomocou tejto smernice určíte názov robota, ktorý má použiť odporúčania v súbore. Týchto robotov je oficiálne vo svete internetu - 302 kusov. Samozrejme, môžete napísať pravidlá pre každého zvlášť, ale ak na to nemáte čas, napíšte:

User-agent: *

* - v tomto príklade znamená "Všetko". Tie. váš súbor robots.txt by mal začínať „pre koho presne“ je súbor určený. Aby ste sa netrápili všetkými názvami robotov, stačí napísať hviezdičku do direktívy user-agent.

Dám vám podrobné zoznamy robotov populárnych vyhľadávačov:

Google- Googlebot- hlavná robota

Iní roboti GoogleNovinky o Googlebotovi- robot na vyhľadávanie správ

Obrázok robota Googlebot- obrázky robotov

Googlebot Video- video robota

Googlebot pre mobil- mobilná verzia robota

AdsBot-Google- robot na kontrolu kvality vstupnej stránky

Mediálni partneri – Google- robot adsense

Yandex - YandexBot- hlavný indexovací robot;

Iné roboty YandexZakázať a povoliť smernice

Zakázať- najzákladnejšie pravidlo v robotoch, práve pomocou tejto smernice zakazujete indexovanie určitých miest na vašej stránke. Smernica je napísaná takto:

Disallow:

Veľmi často môžete vidieť smernicu Disallow: empty, t.j. údajne robotovi hovoríte, že na stránke nie je nič zakázané, indexujte si, čo chcete. Buď opatrný! Ak zadáte / zakážete, potom stránku úplne zatvoríte na indexovanie.

Preto najštandardnejšia verzia robots.txt, ktorá „umožňuje indexovanie celej stránky pre všetky vyhľadávače“ vyzerá takto:

User Agent: * Disallow:

Ak neviete, čo máte napísať do súboru robots.txt, ale už ste o tom niekde počuli, skopírujte vyššie uvedený kód, uložte ho do súboru s názvom robots.txt a nahrajte ho do koreňového adresára vašej stránky. Alebo nič nevytvárajte, pretože aj bez toho budú roboty indexovať všetko na vašom webe. Alebo si prečítajte článok až do konca a pochopíte, čo na stránke zavrieť a čo nie.

Podľa pravidiel pre roboty sa musí vyžadovať smernica o zákaze.

Pomocou tejto smernice môžete zakázať priečinok aj samostatný súbor.

Ak chceš priečinok zamietnuť mal by si napísať:

Disallow: /priečinok/

Ak chceš zakázať konkrétny súbor:

Disallow: /images/img.jpg

Ak chceš zakázať určité typy súborov:

Disallow: /*.png$

Regulárne výrazy nie sú podporované mnohými vyhľadávačmi. Google podporuje.

povoliť— povoľujúca smernica v Robots.txt. Umožňuje robotovi indexovať konkrétnu cestu alebo súbor v adresári odmietnutia. Až donedávna ho používal iba Yandex. Google sa toho chytil a začal to používať tiež. Napríklad:

Povoliť: /obsah Disallow: /

tieto smernice zakazujú indexovanie všetkého obsahu lokality, okrem priečinka s obsahom. Alebo tu sú niektoré populárnejšie smernice v poslednej dobe:

Povoliť: /themplate/*.js Povoliť: /themplate/*.css Zakázať: /template

tieto hodnoty umožňujú indexovanie všetkých CSS a JS súborov na stránke, ale zabráňte indexovaniu všetkého v priečinku šablón. Za posledný rok Google poslal správcom webu množstvo listov s nasledujúcim obsahom:

Googlebot nemôže získať prístup k súborom CSS a JS na webových stránkach

A súvisiaci komentár: Na vašej lokalite sme objavili problém, ktorý môže brániť jej indexovému prehľadávaniu. Googlebot nemôže spracovať kód JavaScript a/alebo súbory CSS z dôvodu obmedzení v súbore robots.txt. Tieto údaje sú potrebné na vyhodnotenie výkonu stránky. Ak je teda prístup k zdrojom zablokovaný, môže to zhoršiť pozíciu vášho webu vo Vyhľadávaní.

Ak do súboru Robots.txt pridáte dva príkazy na povolenie, ktoré sú napísané v poslednom kóde, takéto správy od Googlu neuvidíte.

A pomocou špeciálnych znakov v súbore robots.txt

Teraz o znakoch v smerniciach. Základné znaky (špeciálne znaky) pri zákaze alebo povolení tohto /, *, $

O lomkách (lomka) "/"

Lomka je v súbore robots.txt veľmi klamlivá. Niekoľko desiatokkrát som pozoroval zaujímavú situáciu, keď z nevedomosti pridali do robots.txt:

User-Agent: * Disallow: /

Pretože si niekde prečítali štruktúru stránky a skopírovali si ju k sebe na stránke. Ale v tomto prípade vy zakázať indexovanie celej stránky. Ak chcete zakázať indexovanie adresára so všetkými internými prvkami, určite musíte na koniec umiestniť /. Ak napríklad napíšete Disallow: /seo, potom absolútne všetky odkazy na vašej stránke, ktoré obsahujú slovo seo, nebudú indexované. Aj keď to bude priečinok /seo/, aj keď to bude kategória /seo-tool/, aj keď to bude článok /seo-best-of-the-best-soft.html, toto všetko nebude byť indexované.

Pozorne si všetko prezrite / v súbore robots.txt

Vždy dávajte / na koniec adresárov. Ak nastavíte / na Disallow, zabránite indexovaniu celej stránky, ale ak nenastavíte / na Povoliť, zakážete aj indexovanie celej stránky. / - v istom zmysle znamená "Všetko, čo sa riadi smernicou /".

O hviezdičkách * v súbore robots.txt

Špeciálny znak * znamená akúkoľvek (vrátane prázdnych) sekvencií znakov. Môžete ho použiť kdekoľvek v robotoch, ako je tento:

User-agent: * Disallow: /papka/*.aspx Disallow: /*old

Zakáže všetky súbory s príponou aspx v adresári papka, zakáže aj nielen priečinok /old, ale aj direktívu /papka/old. Zákerné? Preto vám neodporúčam hrať sa so symbolom * vo vašich robotoch.

Štandardne v súbor pravidiel indexovania a zákazu robots.txt je * pre všetky smernice!

O špeciálnom znaku $

Špeciálny znak $ v robotoch ukončuje špeciálny znak *. Napríklad:

Disallow: /menu$

Toto pravidlo zakazuje '/menu', ale nezakazuje '/menu.html', t.j. súbor zakáže vyhľadávacie nástroje iba s príkazom /menu a nemôže zakázať všetky súbory so slovom menu v adrese URL.

hostiteľskej smernice

Pravidlo hostiteľa funguje iba v Yandex, takže je voliteľná, určuje primárnu doménu zo zrkadiel vašich stránok, ak nejaké existujú. Máte napríklad doménu dom.com, ale sú zakúpené a nakonfigurované aj tieto domény: dom2.com, dom3,com, dom4.com a z nich je presmerovanie na hlavnú doménu dom.com

Aby mohol Yandex rýchlo určiť, ktorá z nich je hlavná stránka (hostiteľ), pridajte hostiteľský adresár do súboru robots.txt:

hostiteľ: stránka

Ak vaša stránka nemá zrkadlá, nemôžete predpísať toto pravidlo. Najprv si však skontrolujte svoju stránku podľa IP adresy, je možné, že sa na nej otvára vaša hlavná stránka a mali by ste si zaregistrovať hlavné zrkadlo. Alebo možno niekto skopíroval všetky informácie z vašej stránky a vytvoril presnú kópiu, pomôže vám s tým záznam v súbore robots.txt, ak bol tiež odcudzený.

Položka hostiteľa musí byť jedna av prípade potreby aj s predpísaným portom. (Hostiteľ: site:8080)

Smernica o oneskorenom prehľadávaní

Táto smernica bola vytvorená s cieľom odstrániť možnosť načítania vášho servera. Vyhľadávacie roboty môžu na vašu stránku odosielať stovky žiadostí súčasne a ak je váš server slabý, môže to spôsobiť menšie chyby. Aby sme tomu zabránili, prišli sme s pravidlom pre roboty zdržujúce prehľadávanie – ide o minimálnu dobu medzi načítaním stránok na vašom webe. Predvolenú hodnotu pre túto smernicu sa odporúča nastaviť na 2 sekundy. V robotoch to vyzerá takto:

Oneskorenie indexového prehľadávania: 2

Táto smernica funguje pre Yandex. V Google môžete nastaviť rýchlosť indexového prehľadávania na paneli správcu webu v sekcii Nastavenia lokality v pravom hornom rohu pomocou „ozubeného kolieska“.

Smernica o čistých parametroch

Tento parameter je tiež len pre Yandex. Ak adresy stránok lokality obsahujú dynamické parametre, ktoré neovplyvňujú ich obsah (napríklad: ID relácie, ID používateľov, referrerov atď.), môžete ich opísať pomocou direktívy Clean-param.

Robot Yandex pomocou týchto informácií nebude opakovane načítavať duplicitné informácie. Zvýši sa teda efektivita prehľadávania vašich stránok a zníži sa zaťaženie servera.

Stránka má napríklad stránky:

www.site.com/some_dir/get_book.pl?ref=site_1&book_id=123

Parameter ref sa používa len na sledovanie zdroja, z ktorého bola požiadavka uskutočnená a nemení obsah, na všetkých troch adresách sa zobrazí rovnaká stránka s knihou book_id=123. Potom, ak zadáte smernicu takto:

User-agent: Yandex Disallow: Clean-param: ref /some_dir/get_book.pl

robot Yandex zredukuje všetky adresy stránok na jednu:

www.site.com/some_dir/get_book.pl?ref=site_1&book_id=123,

Ak je na webe dostupná stránka bez parametrov:

www.site.com/some_dir/get_book.pl?book_id=123

potom všetko príde na to, keď to bude robot indexovať. Ostatné stránky na vašej lokalite budú indexovo prehľadávané častejšie, pretože nie je potrebné obnovovať stránky:

www.site.com/some_dir/get_book.pl?ref=site_2&book_id=123

www.site.com/some_dir/get_book.pl?ref=site_3&book_id=123

#pre adresy ako: www.site1.com/forum/showthread.php?s=681498b9648949605&t=8243 www.site1.com/forum/showthread.php?s=1e71c4427317a117a&t=8243 bude obsahovať: Useragent.txt Yandex Disallow: Clean-param: s /forum/showthread.php

Smernica o mapách stránok

Pomocou tejto smernice jednoducho určíte umiestnenie súboru sitemap.xml. Robot si to zapamätá, „ďakuje“ a neustále to analyzuje na danej ceste. Vyzerá to takto:

Sitemap: http://site/sitemap.xml

A teraz sa pozrime na všeobecné otázky, ktoré vznikajú pri zostavovaní robota. Takýchto tém je na internete veľa, preto rozoberieme tie najrelevantnejšie a najčastejšie.

Opravte súbor robots.txt

V tomto slove je veľa „správnych“, pretože pre jednu stránku na jednom CMS to bude správne a na inom CMS bude dávať chyby. "Správne nakonfigurované" pre každú lokalitu je individuálne. V súbore Robots.txt musíte zatvoriť indexovanie tých sekcií a súborov, ktoré používatelia nepotrebujú a nemajú žiadnu hodnotu pre vyhľadávače. Najjednoduchšia a najsprávnejšia verzia súboru robots.txt

User-Agent: * Disallow: Sitemap: http://site/sitemap.xml User-agent: Yandex Disallow: Host: site.com

Tento súbor obsahuje nasledujúce pravidlá: nastavenia pravidiel zákazu pre všetky vyhľadávače (User-Agent: *), indexovanie celej stránky je úplne povolené (“Disallow:” alebo môžete zadať “Allow: /”), hostiteľ je zadané hlavné zrkadlo pre Yandex (hostiteľ: site.ncom) a umiestnenie vášho súboru Sitemap.xml (mapa webu: .

Robots.txt pre WordPress

Opäť je tu veľa otázok, jedna stránka môže byť internetový obchod, druhá blog, tretia je vstupná stránka, štvrtá je stránka s vizitkou spoločnosti a to všetko môže byť na redakčnom systéme WordPress a pravidlách pre roboty budú úplne iné. Tu je môj súbor robots.txt pre tento blog:

User-Agent: * Povoliť: /wp-content/uploads/ Povoliť: /wp-content/*.js$ Povoliť: /wp-content/*.css$ Povoliť: /wp-includes/*.js$ Povoliť: / wp-includes/*.css$ Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /xmlrpc.php Disallow: /template.html Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content Disallow: /category Disallow: /archive Disallow: */trackback/ Disallow: */feed/ Disallow: /?feed= Disallow: /job Disallow: /?.net/sitemap.xml

Je tu veľa nastavení, poďme si ich spoločne rozobrať.

Povoliť vo WordPress. Prvé pravidlá povolení sa týkajú obsahu, ktorý používatelia potrebujú (sú to obrázky v priečinku nahrávania) a robotov (sú to CSS a JS na zobrazovanie stránok). Google na css a js často nadáva, preto sme ich nechali otvorené. Bolo možné použiť metódu všetkých súborov jednoduchým vložením „/*.css$“, ale zákazový riadok presne týchto priečinkov, kde sa súbory nachádzajú, neumožňoval ich použitie na indexovanie, takže som musel napísať úplná cesta k priečinku zákazu.

Povoliť vždy ukazuje na cestu obsahu, ktorý je zakázaný v Disallow. Ak vám niečo nie je zakázané, nemali by ste to predpisovať, povoľte to, údajne si myslíte, že dávate impulz vyhľadávačom, ako napríklad „Poďme, tu je adresa URL, indexujte rýchlejšie.“ To nebude fungovať.

Zakázať vo WordPress. V CMS WP treba zakázať veľa vecí. Množstvo rôznych pluginov, množstvo rôznych nastavení a tém, kopa skriptov a rôznych stránok, ktoré nenesú žiadne užitočné informácie. Išiel som ale ďalej a úplne som zakázal indexovať na svojom blogu všetko, okrem samotných článkov (príspevkov) a stránok (o Autorovi, Službách). Kategórie na blogu som dokonca zatvoril, otvorím ich, keď budú optimalizované na dopyty a keď sa tam objaví textový popis ku každej z nich, ale teraz sú to len duplicitné náhľady záznamov, ktoré vyhľadávače nepotrebujú.

No Host a Sitemap sú štandardné smernice. Iba bolo potrebné vybrať hostiteľa samostatne pre Yandex, ale s tým som sa neobťažoval. Skončime s Robots.txt pre WP.

Ako vytvoriť súbor robots.txt

Nie je to také ťažké, ako sa na prvý pohľad zdá. Stačí si zobrať obyčajný poznámkový blok (Notepad) a skopírovať údaje pre váš web podľa nastavení z tohto článku. Ale ak je to pre vás ťažké, na internete sú zdroje, ktoré vám umožňujú generovať roboty pre vaše stránky:

Nikto nepovie o vašom súbore Robots.txt viac ako títo súdruhovia. Koniec koncov, je to pre nich, že vytvoríte svoj „zakázaný súbor“.

Teraz si povedzme o niektorých malých chybách, ktoré môžu byť v robotoch.

- « Prázdny riadok' - v direktíve user-agent nie je dovolené vytvoriť prázdny reťazec.

- O konflikt medzi dvoma smernice s predponami rovnakej dĺžky má prednosť smernica povoliť.

- Pre každý súbor robots.txt je spracovaný iba jedna hostiteľská smernica. Ak je v súbore zadaných viacero príkazov, robot použije prvý.

- smernice Čistý param je prierezový, takže môže byť uvedený kdekoľvek v súbore robots.txt. Ak existuje niekoľko smerníc, robot ich zohľadní všetky.

- Šesť robotov Yandex nedodržiava pravidlá Robots.txt (YaDirectFetcher, YandexCalendar, YandexDirect, YandexDirectDyn, YandexMobileBot, YandexAccessibilityBot). Ak chcete zabrániť ich indexovaniu na stránke, mali by ste pre každú z nich vytvoriť samostatné parametre používateľského agenta.

- Direktíva používateľského agenta, musí byť vždy napísané nad smernicou zamietnuť.

- Jeden riadok pre jeden adresár. Nemôžete napísať viacero adresárov na jeden riadok.

- Názov súboru malo by to byť len takto: robots.txt. Žiadny súbor Robots.txt, ROBOTS.txt atď. Len malé písmená v názve.

- V smernici hostiteľ mali by ste napísať cestu k doméne bez http a bez lomítok. Nesprávne: Hostiteľ: http://www.site.ru/, Správne: Hostiteľ: www.site.ru

- Keď stránka používa zabezpečený protokol https v smernici hostiteľ(pre robota Yandex) musí byť špecifikovaný v protokole, takže hostiteľ: https://www.site.ru

Tento článok bude aktualizovaný, keď prídu zaujímavé otázky a nuansy.

Bol s tebou, lenivý Staurus.

Robots.txt je súbor služby, ktorý slúži ako odporúčanie na obmedzenie prístupu k obsahu webových dokumentov pre vyhľadávače. V tomto článku rozoberieme nastavenie Robots.txt, popis direktív a ich kompiláciu pre populárny CMS.

Tento súbor Robot sa nachádza v koreňovom adresári vašej stránky a otvára sa / upravuje pomocou jednoduchého poznámkového bloku, odporúčam Notepad ++. Pre tých, ktorí neradi čítajú - je tu VIDEO, pozri na konci článku 😉

Prečo je potrebný súbor robots.txt

Ako som uviedol vyššie, pomocou súboru robots.txt môžeme obmedziť prístup vyhľadávacích robotov k dokumentom, t.j. priamo ovplyvňujeme indexovanie stránky. Najčastejšie uzavreté z indexovania:

- Súbory a priečinky služby CMS

- duplikáty

- Dokumenty, ktoré nie sú pre používateľa užitočné

- Nie jedinečné stránky

Uveďme si konkrétny príklad:

Internetový obchod, ktorý predáva topánky a je implementovaný na jednom z populárnych CMS, a nie práve najlepším spôsobom. Okamžite viem povedať, aké budú vo výsledkoch vyhľadávacie stránky, stránkovanie, košík, niektoré súbory motorov atď. To všetko budú duplikáty a servisné súbory, ktoré sú pre používateľa zbytočné. Preto by mali byť zatvorené z indexovania, a ak stále existuje sekcia „Novinky“, do ktorej sa kopírujú rôzne zaujímavé články z konkurenčných stránok, potom nie je potrebné premýšľať, okamžite ju zatvoríme.

Preto musíme získať súbor robots.txt, aby sa do problému nedostal odpad. Nezabudnite, že súbor sa musí otvoriť na adrese http://site.ru/robots.txt.

smernice robots.txt a pravidlá prispôsobenia

user-agent. Toto je výzva na konkrétneho robota vyhľadávacieho nástroja alebo na všetky roboty. Ak je zadaný konkrétny názov robota, napríklad „YandexMedia“, potom sa naň nepoužívajú všeobecné príkazy používateľského agenta. Príklad písania:

User-agent: YandexBot Disallow: /cart # bude používať iba hlavný indexovací robot Yandex

Disallow/Allow. Ide o zákaz/povolenie indexovať konkrétny dokument alebo sekciu. Na poradí zápisu nezáleží, ale s 2 direktívami a rovnakou predponou má prednosť "Povoliť". Vyhľadávací robot ich prečíta podľa dĺžky predpony, od najmenšej po najväčšiu. Ak potrebujete zakázať indexovanie stránky, stačí zadať relatívnu cestu k nej (Disallow: /blog/post-1).

User-agent: Yandex Disallow: / Allow: /articles # Zakázať indexovanie stránok, okrem 1 sekcie článkov

Regulárne výrazy s * a $. Hviezdička znamená ľubovoľnú postupnosť znakov (vrátane prázdnych). Znak dolára znamená prerušenie. Príklady použitia:

Disallow: /page* # zakázať všetky stránky, konštrukcie http://site.ru/page Disallow: /arcticles$ # zakázať iba stránku http://site.ru/articles, povoliť stránky http://site.ru/ články /nové

Smernica Sitemap. Ak používate - v súbore robots.txt by to malo byť označené takto:

Sitemap: http://site.ru/sitemap.xml

hostiteľskej smernice. Ako viete, stránky majú zrkadlá (čítaj,). Toto pravidlo nasmeruje vyhľadávacieho robota na hlavné zrkadlo vášho zdroja. Odkazuje na Yandex. Ak máte zrkadlo bez WWW, potom píšeme:

Hostiteľ: site.ru

Crawl-oneskorenie. Nastavuje oneskorenie (v sekundách) medzi sťahovaním vašich dokumentov robotmi. Píše sa za príkazmi Disallow/Allow.

Oneskorenie indexového prehľadávania: 5 # časový limit 5 sekúnd

Čistý param. Označuje vyhľadávaciemu robotovi, že nepotrebuje sťahovať ďalšie duplicitné informácie (relácia, referrer, ID používateľov). Clean-param by mal byť napísaný pre dynamické stránky:

Clean-param: ref /category/books # označuje, že naša stránka je hlavná a http://site.ru/category/books?ref=yandex.ru&id=1 je tá istá stránka, ale s parametrami

Hlavné pravidlo: robots.txt musí byť napísaný malými písmenami a umiestnený v koreňovom adresári stránky. Príklad štruktúry súboru:

User-agent: Yandex Disallow: /cart Povoliť: /cart/images Sitemap: http://site.ru/sitemap.xml Hostiteľ: site.ru Crawl-delay: 2

Metaznačka robotov a ako je napísaná

Túto možnosť zákazu stránok lepšie berie do úvahy vyhľadávač Google. Yandex rovnako dobre zohľadňuje obe možnosti.

Má 2 smernice: follow/nofollow a index/noindex. Ide o povolenie/zákaz nasledujúcich odkazov a povolenie/zákaz indexovania dokumentov. Smernice je možné písať spolu, pozri príklad nižšie.

Pre každú jednotlivú stránku môžete napísať značku

nasledujúce:Opravte súbory robots.txt pre populárne CMS

Príklad súboru Robots.txt pre WordPress

Nižšie si môžete pozrieť moju verziu z tohto Seo blogu.

User-agent: Yandex Disallow: /wp-content/uploads/ Allow: /wp-content/uploads/*/*/ Disallow: /wp-login.php Disallow: /wp-register.php Disallow: /xmlrpc.php Disallow : /template.html Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: / wp-trackback Disallow: /wp-feed Disallow: /wp-comments Disallow: */trackback Disallow: */feed Disallow: */comments Disallow: /tag Disallow: /archive Disallow: */trackback/ Disallow: */feed/ Disallow: */comments/ Disallow: /?feed= Disallow: /?.php Disallow: /wp-register.php Disallow: /xmlrpc.php Disallow: /template.html Disallow: /cgi-bin Disallow: /wp-admin Disallow: /wp-includes Disallow: /wp-content/plugins Disallow: /wp-content/cache Disallow: /wp-content/themes Disallow: /wp-trackback Disallow: /wp-feed Disallow: /wp-comments Disallow: */trackback Disallow: */feed Disallow: */comments Disallow: /tag Disallow: /archive Disallow: */trackback/ Disallo w: */feed/ Disallow: */comments/ Disallow: /?feed= Disallow: /?.xml

Trackbacky zakazujem, pretože duplikuje časť článku v komentároch. A ak existuje veľa spätných odkazov, dostanete kopu rovnakých komentárov.

Snažím sa zavrieť servisné priečinky a súbory akéhokoľvek CMS. Nechcem, aby sa dostali do indexu (aj keď ich vyhľadávače aj tak neberú, ale nebude to horšie).

Krmivá (krmivo) by mali byť uzavreté, pretože. ide o čiastočné alebo úplné duplikáty stránok.

Tagy sú uzavreté, ak ich nepoužívame alebo sme príliš leniví na to, aby sme ich optimalizovali.

Príklady pre iné CMS

Ak chcete stiahnuť správnych robotov pre požadovaný CMS, jednoducho kliknite na príslušný odkaz.

Súbor robots.txt sa nachádza v koreňovom adresári vašej stránky. Napríklad na www.example.com by adresa súboru robots.txt bola www.example.com/robots.txt. Ide o obyčajný textový súbor, ktorý je v súlade so štandardom vylúčenia robotov a obsahuje jedno alebo viacero pravidiel, z ktorých každé zakazuje alebo povoľuje prístup jedného alebo druhého prehľadávača k určitej ceste na stránke.

Nižšie je uvedený príklad jednoduchého súboru robots.txt, ktorý obsahuje dve pravidlá a ich výklad.

# Používateľský agent pravidla 1: Googlebot Disallow: /nogooglebot/ # Používateľský agent pravidla 2: * Povoliť: / Sitemap: http://www.example.com/sitemap.xml

Výklad

- Používateľský agent s názvom Googlebot nesmie indexovo prehľadávať adresár http://example.com/nogooglebot/ a jeho podadresáre.

- Všetci ostatní používateľskí agenti majú prístup k celej stránke (možno vynechať, výsledok je rovnaký, pretože plný prístup je štandardne udelený).

- Súbor Sitemap táto stránka sa nachádza na adrese http://www.example.com/sitemap.xml.

Tu je niekoľko tipov na prácu so súbormi robots.txt. Odporúčame, aby ste sa naučili úplnú syntax súborov robots.txt, pretože pravidlá syntaxe používané na vytváranie súborov robots.txt nie sú zrejmé a musíte im rozumieť.

Formát a rozloženie

Súbor robots.txt môžete vytvoriť takmer v akomkoľvek textovom editore (musí podporovať kódovanie ASCII alebo UTF-8). Nepoužívajte textové procesory: často ukladajú súbory v proprietárnom formáte a pridávajú do nich nepovolené znaky, ako napríklad kučeravé úvodzovky, ktoré vyhľadávacie roboty nerozpoznajú.

Pri vytváraní a testovaní týchto súborov použite nástroj na kontrolu súborov robots.txt. Umožňuje vám analyzovať syntax súboru a zistiť, ako bude fungovať na vašom webe.

Pravidlá pre formát súboru a umiestnenie

- Súbor musí mať názov robots.txt.

- Na stránke by mal byť iba jeden takýto súbor.

- Musí byť umiestnený súbor robots.txt koreňový adresár stránky. Ak chcete napríklad ovládať prehľadávanie všetkých stránok na http://www.example.com/ , umiestnite súbor robots.txt na http://www.example.com/robots.txt . Nesmie byť v podadresári(napríklad pri http://example.com/pages/robots.txt). Ak máte problémy s prístupom do koreňového adresára, kontaktujte svojho poskytovateľa hostingu. Ak nemáte prístup do koreňového adresára lokality, použite alternatívnu metódu blokovania, ako sú metaznačky.

- Súbor robots.txt je možné pridať k adresám pomocou subdomény(napr. http:// webovej stránky.example.com/robots.txt) alebo neštandardné porty (napríklad http://example.com: 8181 /robots.txt).

- Komentáre sú akékoľvek riadky, ktoré začínajú znakom libry (#).

Syntax

- Súbor robots.txt musí byť textový súbor s kódovaním ASCII alebo UTF-8. Iné znaky nie sú povolené.

- Súbor robots.txt môže pozostávať z jedného alebo viacerých pravidlá.

- pravidlo musí obsahovať niekoľko smernice(návod), z ktorých každý by mal byť uvedený na samostatnom riadku.

- Pravidlo obsahuje nasledujúce informácie:

- Ku ktorému užívateľský agent platí pravidlo.

- mať prístup.

- Ktoré adresáre alebo súbory má tento agent Bez prístupu.

- Pravidlá sa spracúvajú zhora nadol. Používateľský agent sa môže riadiť iba jedným pravidlom, ktoré je pre neho vhodné a ktoré bude spracované ako prvé.

- Predpokladá sa predvolené nastavenieže ak prístup na stránku alebo adresár nie je blokovaný pravidlom Disallow:, používateľský agent to zvládne.

- pravidlá rozlišovať malé a veľké písmená. Napríklad pravidlo Disallow: /file.asp sa vzťahuje na adresu URL http://www.example.com/file.asp , ale nie na adresu http://www.example.com/File.asp .

Smernice používané v súboroch robots.txt

- užívateľský agent: Povinné použitie, v jednom pravidle môže byť jedno alebo viac takýchto pravidiel. Definuje robota vyhľadávač, na ktorý sa pravidlo vzťahuje. Tento riadok je prvý v akomkoľvek pravidle. Väčšina z nich je uvedená v databáze internetových botov alebo v zozname botov Google. Zástupný znak * je podporovaný na označenie predpony alebo prípony cesty alebo celej cesty. Na zablokovanie všetkých prehľadávačov použite znak (*), ako je uvedené v príklade nižšie ( okrem robotov AdsBot, ktoré je potrebné špecifikovať samostatne). Odporúčame vám oboznámiť sa so zoznamom robotov Google. Príklady:# Príklad 1: Blokovať iba Googlebot User-agent: Googlebot Disallow: / # Príklad 2: Blokovať Googlebot a Adsbot User-agent: Googlebot User-agent: AdsBot-Google Disallow: / # Príklad 3: Blokovať všetky prehľadávače okrem AdsBot User-agent :* Disallow: /

- Disallow: . Ukazuje na adresár alebo stránku v koreňovej doméne, ktorú nemôže prehľadávať používateľský agent definovaný vyššie. Ak ide o stránku, musí byť uvedená úplná cesta k nej, ako v paneli s adresou prehliadača. Ak ide o adresár, cesta musí končiť lomkou (/). Zástupný znak * je podporovaný na označenie predpony alebo prípony cesty alebo celej cesty.

- povoliť: Každé pravidlo musí mať aspoň jednu direktívu Disallow: alebo Allow:.. Ukazuje na adresár alebo stránku v koreňovej doméne, ktorú nemôže prehľadávať používateľský agent definovaný vyššie. Používa sa na zrušenie pravidla Disallow a povolenie skenovania podadresára alebo stránky v adresári, ktorý je pre skenovanie uzavretý. Ak ide o stránku, musí byť uvedená úplná cesta k nej, ako v paneli s adresou prehliadača. Ak ide o adresár, cesta musí končiť lomkou (/). Zástupný znak * je podporovaný na označenie predpony alebo prípony cesty alebo celej cesty.

- mapa stránok: Voliteľne môže existovať niekoľko alebo žiadna z týchto smerníc. Ukazuje na umiestnenie súboru Sitemap používaného touto stránkou. Adresa URL musí byť úplná. Spoločnosť Google nespracúva ani neoveruje varianty adries URL s predponami http a https alebo s prvkom www alebo bez neho. Súbory Sitemap informujú Google, aký obsah potrebu naskenovaný a ako ho odlíšiť od obsahu, ktorý môcť alebo je zakázané skenovať. Získajte viac informácií o súboroch Sitemap. Príklad: Sitemap: https://example.com/sitemap.xml Sitemap: http://www.example.com/sitemap.xml

Neznáme kľúčové slová sú ignorované.

Ešte jeden príklad

Súbor robots.txt pozostáva z jednej alebo viacerých skupín pravidiel. Každá sada začína reťazcom User-agent, ktorý špecifikuje robota, ktorý dodržiava pravidlá v skupine. Tu je príklad súboru s dvoma pravidlami; sú vysvetlené vloženými komentármi:

# Zablokujte Googlebotovi prístup na example.com/adresár1/... a example.com/adresár2/... # ale povoľte prístup k adresáru2/podadresár1/... # Prístup ku všetkým ostatným adresárom je štandardne povolený. User-agent: googlebot Disallow: /directory1/ Disallow: /directory2/ Allow: /directory2/subdirectory1/ # Blokovať prístup iných vyhľadávačov na celú stránku. User-agent: othercrawler Disallow: /

Úplná syntax súboru robots.txt

Úplná syntax je popísaná v tomto článku. Odporúčame, aby ste sa s ním oboznámili, pretože v syntaxi súboru robots.txt sú niektoré dôležité nuansy.

Užitočné pravidlá

Tu je niekoľko bežných pravidiel pre súbor robots.txt:

| pravidlo | Príklad |

|---|---|

| Zabráňte prehľadávaniu celého webu. Upozorňujeme, že v niektorých prípadoch môžu byť adresy URL stránok indexované, aj keď neboli prehľadané. Upozorňujeme, že toto pravidlo neplatí pre AdsBots, ktoré musia byť uvedené samostatne. | User-agent: * Disallow: / |

| Aby sa zabránilo skenovaniu adresára a celého jeho obsahu, za názvom adresára vložte lomku. Na ochranu dôverných informácií nepoužívajte súbor robots.txt! Na tieto účely by sa mala použiť autentifikácia. Adresy URL zablokované súborom robots.txt je možné indexovať a obsah súboru robots.txt môže zobraziť každý používateľ, a tak zistiť umiestnenie súborov s dôvernými informáciami. | User-agent: * Disallow: /calendar/ Disallow: /junk/ |

| Povoliť indexové prehľadávanie iba pre jeden prehľadávač | User-agent: Googlebot-news Povoliť: / User-agent: * Disallow: / |

| Povoliť indexové prehľadávanie všetkým indexovým prehľadávačom okrem jedného | User-agent: Unnecessarybot Disallow: / User-agent: * Allow: / |

|

Zakázať skenovanie jednotlivej stránky, uveďte túto stránku za lomkou. |

Disallow: /private_file.html |

|

Ak chcete skryť konkrétny obrázok pred robotom Obrázkov Google |

User-agent: Googlebot-Image Disallow: /images/dogs.jpg |

|

Ak chcete skryť všetky obrázky z vášho webu pred robotom Obrázkov Google |

User-agent: Googlebot-Image Disallow: / |

|

Aby sa zabránilo skenovaniu všetkých súborov určitého typu(v tomto prípade GIF) |

User-agent: Googlebot Disallow: /*.gif$ |

|

Ak chcete zablokovať konkrétne stránky na svojom webe, ale naďalej na nich zobrazovať reklamy AdSense, použite pravidlo Disallow pre všetky roboty okrem Mediapartners-Google. Výsledkom je, že tento robot bude môcť pristupovať na stránky odstránené z výsledkov vyhľadávania, aby mohol vybrať reklamy, ktoré sa zobrazia konkrétnemu používateľovi. |

User-agent: * Disallow: / User-agent: Mediapartners-Google Allow: / |

| Ak chcete zadať adresy URL končiace určitými znakmi, použite symbol $. Napríklad pre adresy URL končiace na .xls použite nasledujúci kód: | User-agent: Googlebot Disallow: /*.xls$ |

Bol tento článok nápomocný?

Ako možno tento článok vylepšiť?

Vydali sme novú knihu „Marketing obsahu sociálnych médií: Ako sa dostať do hlavy predplatiteľov a prinútiť ich, aby sa zamilovali do vašej značky.“

Robots.txt je textový súbor, ktorý obsahuje informácie pre prehľadávače, ktoré pomáhajú indexovať portálové stránky.

Viac videí na našom kanáli - naučte sa internetový marketing so SEMANTICOU

![]()

Predstavte si, že ste na honbe za pokladom na ostrove. Máš mapu. Trasa je tam vyznačená: „Priblížte sa k veľkému pňu. Z nej urobte 10 krokov na východ, potom sa dostaňte k útesu. Odbočte doprava, nájdite jaskyňu."

Toto sú pokyny. Po nich nasledujete trasu a nájdete poklad. Vyhľadávací robot tiež funguje približne rovnakým spôsobom, keď začne indexovať web alebo stránku. Nájde súbor robots.txt. Číta, ktoré stránky by sa mali indexovať a ktoré nie. A podľa týchto príkazov obíde portál a pridá jeho stránky do indexu.

Na čo slúži robots.txt?

Začnú navštevovať stránky a indexovať stránky po nahratí stránky na hosting a zaregistrovaní DNS. Robia svoju prácu bez ohľadu na to, či máte nejaké technické súbory alebo nie. Roboti vyhľadávačom naznačujú, že pri prehľadávaní webovej stránky musia brať do úvahy parametre, ktoré sa na nej nachádzajú.

Neprítomnosť súboru robots.txt môže viesť k problémom s rýchlosťou prehľadávania stránky a k výskytu odpadu v indexe. Nesprávna konfigurácia súboru je spojená s vylúčením dôležitých častí zdroja z indexu a prítomnosťou nepotrebných stránok vo výsledkoch vyhľadávania.

To všetko vedie k problémom s propagáciou.

Pozrime sa bližšie na to, aké pokyny obsahuje tento súbor a ako ovplyvňujú správanie robota na vašom webe.

Ako vytvoriť súbor robots.txt

Najprv skontrolujte, či máte tento súbor.

Zadajte adresu stránky do panela s adresou prehliadača a názov súboru cez lomku, napríklad https://www.xxxxx.ru/robots.txt

Ak je súbor prítomný, na obrazovke sa zobrazí zoznam jeho parametrov.

Ak súbor neexistuje:

- Súbor sa vytvorí v obyčajnom textovom editore, ako je Poznámkový blok alebo Poznámkový blok ++.

- Musíte nastaviť názov robota, príponu.txt. Zadajte údaje v súlade s akceptovanými štandardmi formátovania.

- Chyby môžete skontrolovať pomocou služieb, ako je webmaster Yandex. Tam musíte v sekcii "Nástroje" vybrať položku "Analyze robots.txt" a postupovať podľa pokynov.

- Keď je súbor pripravený, nahrajte ho do koreňového adresára lokality.

Pravidlá prispôsobenia

Vyhľadávače majú viac ako jedného robota. Niektoré roboty indexujú iba textový obsah, niektoré iba grafický obsah. A samotné vyhľadávače môžu mať rôzne schémy fungovania prehľadávačov. Toto je potrebné vziať do úvahy pri zostavovaní súboru.

Niektorí z nich môžu ignorovať niektoré pravidlá, napríklad GoogleBot nereaguje na informácie o tom, ktoré zrkadlo stránky sa považuje za hlavné. Ale vo všeobecnosti vnímajú a riadia sa súborom.

Syntax súboru

Parametre dokumentu: meno robota (bota) "User-agent", príkazy: povolenie "Povoliť" a zákaz "Zakázať".

Teraz existujú dva kľúčové vyhľadávacie nástroje: Yandex a Google, pri zostavovaní stránky je dôležité vziať do úvahy požiadavky oboch.

Formát na vytváranie záznamov je nasledujúci, všimnite si požadované medzery a prázdne riadky.

Direktíva používateľského agenta

Robot hľadá položky, ktoré začínajú User-agent, musia obsahovať označenie mena vyhľadávacieho robota. Ak nie je zadaný, prístup robotov sa považuje za neobmedzený.

Zakázať a povoliť smernice

Ak potrebujete zakázať indexovanie v súbore robots.txt, použite možnosť Disallow. S jeho pomocou obmedzujú prístup robota na stránku alebo do niektorých sekcií.

Ak robots.txt neobsahuje ani jednu direktívu „Disallow“, má sa za to, že indexovanie celej stránky je povolené. Zvyčajne sa zákazy píšu za každým robotom zvlášť.

Všetky informácie za znakom # sú komentárom a nie sú strojovo čitateľné.

Povoliť sa používa na povolenie prístupu.

Symbol hviezdičky znamená, že sa vzťahuje na všetky: User-agent: *.

Táto možnosť naopak znamená úplný zákaz indexovania pre každého.

Zabrániť prezeraniu celého obsahu konkrétneho priečinka adresára

Ak chcete zablokovať jeden súbor, musíte zadať jeho absolútnu cestu

Smernice Sitemap, Host

Pre Yandex je obvyklé uviesť, ktoré zrkadlo chcete označiť ako hlavné. A Google, ako si pamätáme, to ignoruje. Ak neexistujú žiadne zrkadlá, opravte, ako si myslíte, že je správne napísať názov vašej webovej stránky s alebo bez www.

Smernica o čistých parametroch

Môže sa použiť, ak adresy URL webových stránok obsahujú premenlivé parametre, ktoré neovplyvňujú ich obsah (môžu to byť ID používateľov, referrery).

Napríklad v adrese stránky „ref“ definuje zdroj návštevnosti, t.j. označuje, odkiaľ návštevník prišiel na stránku. Stránka bude rovnaká pre všetkých používateľov.

Robot môže byť na to nasmerovaný a nebude sťahovať duplicitné informácie. Tým sa zníži zaťaženie servera.

Smernica o oneskorenom prehľadávaní

S pomocou môžete určiť, s akou frekvenciou bude robot načítavať stránky na analýzu. Tento príkaz sa používa, keď je server preťažený a označuje, že proces obchádzania je potrebné urýchliť.

chyby v súbore robots.txt

- Súbor sa nenachádza v koreňovom adresári. Robot to nebude hľadať hlbšie a nebude to brať do úvahy.

- Písmená v názve musia byť malé latinky.

Chyba v názve, občas im chýba písmeno S na konci a napíšu robot. - V súbore robots.txt nemôžete použiť znaky cyriliky. Ak potrebujete zadať doménu v ruštine, použite formát v špeciálnom kódovaní Punycode.

- Toto je metóda na konverziu názvov domén na sekvenciu znakov ASCII. Na tento účel môžete použiť špeciálne prevodníky.

Toto kódovanie vyzerá takto:

website.rf = xn--80aswg.xn--p1ai

Ďalšie informácie o tom, čo treba zatvoriť v súbore robots txt a o nastaveniach v súlade s požiadavkami vyhľadávacích nástrojov Google a Yandex, nájdete v referenčných dokumentoch. Rôzne cm môžu mať tiež svoje vlastné charakteristiky, to by sa malo vziať do úvahy.

Rozmýšľame, ako obnoviť Skype na prenosnom počítači

Fixies masters plná verzia Fixies hra plná verzia stiahnutá do vášho počítača

Inštalácia alebo aktualizácia, oprava chýb Net framework 3

Virtuálne meny a virtuálne burzy vo svete

Zlaté čísla Ako predať krásne telefónne číslo